L’Hpc (High Performance Computing) è basato su architetture di calcolo parallelo, che sfruttano centinaia o migliaia di nodi interconnessi per elaborare grandi volumi di dati. I sistemi Hpc sono capaci di eseguire trilioni di operazioni al secondo, abilitando simulazioni complesse e modelli predittivi su scala planetaria.

A fianco dell’Hpc, le Gpu (Graphics Processing Unit) general-purpose (Gpgpu) si sono affermate come acceleratori computazionali fondamentali per l’addestramento di reti neurali profonde e per l’elaborazione massiva di immagini e video. L’utilizzo di Gpu è particolarmente intenso nei centri di ricerca, nei laboratori di AI e nei data center dedicati all’elaborazione di modelli linguistici avanzati.

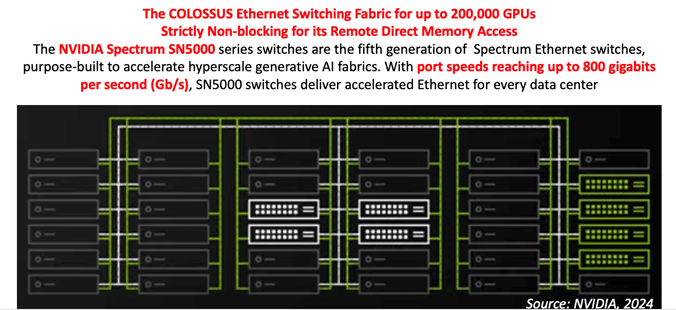

La figura sottostante mostra un esempio avanzato di architettura di interconnessione per sistemi di supercalcolo ad alte prestazioni progettati specificamente per l’intelligenza artificiale generativa su larga scala. In particolare, viene descritto il caso del supercomputer “Colossus 1” sviluppato nel 2024 a Memphis da xAI, azienda di Elon Musk, per l’addestramento del Large Language Model detto Grok , che prevede l’impiego di fino a 200.000 unità di elaborazione grafica Gpu della famiglia Nvidia Hopper, collegate tra loro mediante un’infrastruttura di rete Ethernet di nuova generazione.

Indice degli argomenti

La caratteristica dell’architettura di rete

La caratteristica saliente di questa architettura è l’utilizzo di una rete di interconnessione Ethernet completamente “non-bloccante”, cioè priva di colli di bottiglia nell’accesso simultaneo alla memoria distribuita delle Gpu. Questo aspetto è essenziale per garantire prestazioni elevate in ambienti dove migliaia o decine di migliaia di Gpu devono comunicare tra loro in tempo reale, come nel caso dell’addestramento di modelli di intelligenza artificiale. Una rete non-bloccante assicura che ogni Gpu possa accedere direttamente alla memoria di altre Gpu attraverso protocolli come Rdma (Remote Direct Memory Access), minimizzando la latenza e massimizzando il throughput.

Il cuore tecnologico di questa infrastruttura è rappresentato dagli switch Ethernet della serie Nvidia Spectrum SN5000. Questi dispositivi costituiscono la quinta generazione della linea Spectrum e sono stati progettati specificamente per rispondere alle esigenze dei data center AI-driven. La novità più rilevante riguarda le prestazioni delle porte di interconnessione, che possono raggiungere velocità di trasferimento dati fino a 800 gigabit al secondo (Gbit/s). Si tratta di una soglia mai raggiunta prima in ambito Ethernet standard, che avvicina la rete ai livelli di prestazione tipici delle soluzioni proprietarie o delle tecnologie InfiniBand, finora prevalenti nei sistemi Hpc tradizionali.

L’adozione di Ethernet ad altissima velocità come base per gli “AI Fabric” rappresenta un cambiamento strategico nel design dei data center. Mentre in passato l’Ethernet era percepita come una tecnologia general-purpose meno performante rispetto a InfiniBand, oggi la sua evoluzione verso velocità multi-centinaia di Gbit/s, unita alla compatibilità con gli standard esistenti e alla disponibilità di soluzioni su larga scala, la rende una piattaforma ideale per le esigenze delle architetture AI iperscalari. Inoltre, l’impiego di switch intelligenti con capacità di telemetria, gestione dinamica del traffico e supporto nativo a Rdma consente di ottenere benefici concreti in termini di scalabilità, efficienza energetica e flessibilità operativa.

La rappresentazione grafica nella parte inferiore della figura raffigura una tipica topologia di rete AI Fabric: rack di Gpu collegati in modo denso e simmetrico a una gerarchia di switch ad alta capacità, con interconnessioni multiple per garantire ridondanza e bilanciamento del carico. Questo schema supporta una comunicazione a bassa latenza tra tutte le unità elaborative, elemento essenziale per l’addestramento distribuito di modelli di deep learning con miliardi di parametri, come quelli usati nei foundation model.

Verso Colossus 2

Memphis, Tenessee: qui, nel 2024 l’azienda xAI ha costruito il gigantesco data center Colossus 1 a Bluff City. La scelta di Memphis è mirata: la città offre un sito industriale abbandonato, vicino a infrastrutture esistenti e con disponibilità di energia e acqua. Musk ha trasformato l’ex fabbrica Electrolux in un hub tecnologico.

Il progetto successivo, chiamato “Colossus 2”, prevede la costruzione di un data center fino a 5 volte più potente del predecessore per l’addestramento di modelli di intelligenza artificiale e una centrale elettrica in grado di generare oltre un gigawatt di potenza. L’obiettivo è infatti costruire un impianto capace di connettere 550.000 Gpu Nvidia, con la possibilità di espansione fino a un milione di unità. Secondo le stime del Wall Street Journal, l’intero progetto potrebbe costare decine di miliardi di dollari. Musk punta a completare Colossus 2 entro la fine del 2025, realizzando così il più grande supercomputer del mondo. L’obiettivo finale è permettere a Grok e ai futuri modelli di xAI di competere e superare i prodotti concorrenti di OpenAI, Google e Anthropic.