L’intelligenza artificiale sta spingendo nuovi servizi e nuove modalità d’uso lungo tutta la catena mobile, mentre la standardizzazione del 6G entra nella fase in cui le scelte iniziano a pesare davvero. Uno scenario che obbliga a riflettere su quanto deve essere flessibile lo standard se i casi d’uso alimentati dall’AI cambiano più in fretta dei cicli tipici delle reti.

Nel report “AI Surge and its Implications for 6G” la Next Generation Mobile Networks Alliance (NGMN) prova a tradurre in requisiti e priorità “da operatori” un fenomeno che finora, spesso, è stato trattato in modo più astratto o “da laboratorio”. Il messaggio chiave che emerge è che la crescita e la diversificazione dei casi d’uso impone elasticità nella definizione degli standard, perché il traffico, i modelli di servizio e persino il “tipo” di informazione scambiata rischiano di cambiare natura.

In questo quadro la rete deve diventare più capace di sostenere servizi guidati da algoritmi e agenti, ma non può permettersi di buttare a mare investimenti, processi operativi e interoperabilità costruiti con il 5G.

Indice degli argomenti

Tre dimensioni per capire l’urto: traffico, “network for AI” e “AI for network”

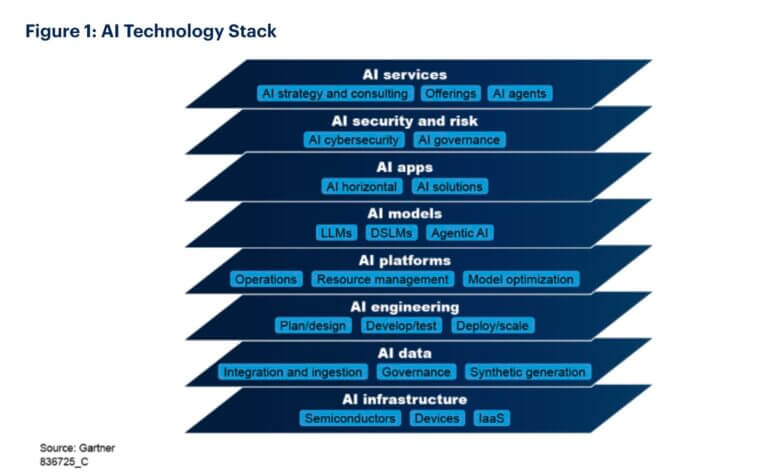

L’analisi guarda all’impatto del traffico generato dai nuovi servizi, alle capacità di rete necessarie per supportarli (quindi una rete “per” l’intelligenza artificiale), e infine al ruolo della stessa intelligenza artificiale come abilitatore dell’evoluzione architetturale (una intelligenza artificiale “per” la rete). È una distinzione utile perché evita di immaginare che basti “aggiungere” AI qua e là per essere pronti alla prossima generazione, senza interrogarsi su quali parti del sistema debbano davvero cambiare e con quale giustificazione economica e operativa.

“Nel testo di accompagnamento, il presidente del Board NGMN Laurent Leboucher mette l’accento proprio su questa esigenza di non irrigidire l’evoluzione: “Mentre la standardizzazione del 6G entra in una fase cruciale, la rapida crescita dell’intelligenza artificiale e degli agenti di AI presenta sia opportunità sia sfide per gli operatori di rete mobile – spiega Laurent Leboucher, presidente del Board della NGMN Alliance e CTO ed EVP Networks del gruppo Orange – Considerata la varietà dei futuri casi d’uso e delle applicazioni basate sull’AI, è essenziale che gli standard del 6G consentano adattabilità senza imporre cambiamenti architetturali dirompenti. La flessibilità sarà fondamentale per accogliere l’evoluzione dei casi d’uso dell’AI tra dispositivi, reti e regioni”.

Il punto non è soltanto “quanto traffico in più” arriverà, ma come arriverà, dove si concentrerà, e con quale asimmetria tra uplink e downlink. E soprattutto: quanto è realistico fissare oggi requisiti rigidi quando la traiettoria dei modelli – e il loro posizionamento tra device, edge e cloud – è ancora in piena trasformazione.

Il nodo del traffico: dal video “umano” alle comunicazioni tra agenti, e l’incognita uplink

L’uso mobile contemporaneo è dominato dal video – evidenzia lo studio – e una parte rilevante della domanda è concentrata in poche applicazioni. Da qui deriva un’osservazione cruciale ovvero che, anche se le applicazioni basate su intelligenza artificiale crescono rapidamente, oggi il loro contributo al traffico mobile resta limitato, perché molte interazioni sono ancora testuali. Il salto potrebbe arrivare quando l’esperienza diventerà davvero multimodale e quando gli agenti inizieranno a “percepire” e agire, scambiandosi non solo parole, ma flussi audio-video, dati sensoriali, modelli e rappresentazioni latenti.

E in uno scenario siffatto l’ottimizzazione dei modelli, l’aumento delle capacità di calcolo su dispositivo, i vincoli regolatori e privacy (si pensi a occhiali AR che riprendono continuamente l’ambiente) possono frenare o accelerare scenari molto diversi. La richiesta esplicita agli organismi di standardizzazione è di lavorare su meccanismi che consentano aggiustamenti anche semi-permanenti del rapporto uplink/downlink, senza ogni volta dover intervenire in modo “traumatico” sulle specifiche, e con un occhio al tema – spesso sottovalutato – del miglioramento della copertura in uplink.

C’è poi un cambiamento qualitativo del traffico che vale più di qualunque previsione numerica: si passa da contenuti pensati per l’uomo (video, immagini, voce) a contenuti “machine-oriented”, come vettori di caratteristiche, aggiornamenti di modelli e scambi tra agenti. Questo non significa solo pacchetti diversi ma anche criteri diversi di priorità, sicurezza, tracciabilità, e anche metriche nuove per capire cosa stia accadendo davvero in rete.

Prestazioni sì, ma solo quando generano valore: la lezione del “bottleneck” sul calcolo

Uno dei passaggi più interessanti del report è la critica implicita alla corsa al requisito “estremo” come default. NGMN richiama la necessità di validare qualsiasi miglioramento prestazionale in termini di valore di business, visto che non tutto richiede latenza minima assoluta, e in molte esperienze conversazionali l’utente tollera ritardi di qualche millisecondo senza percepire un peggioramento significativo.

Soprattutto, NGMN ricorda che nei servizi generativi odierni spesso il collo di bottiglia non è la rete, ma il tempo di elaborazione dei modelli, che richiedono infrastrutture specializzate. È un richiamo a non confondere la “vetrina” (la risposta dell’assistente) con la “macchina” che la produce. Questo, però, non porta a sminuire la rete, al contrario, suggerisce che quando l’AI si sposta verso esperienze immersive e interattive (XR, AR/VR, scenari in tempo reale), allora la qualità del servizio torna centrale e va gestita in modo più stretto, con controllo fine di throughput, latenza e policy.

In altre parole: la prossima generazione non può essere solo una gara di numeri, deve essere una piattaforma capace di offrire ciò che serve “quando serve” e al costo (anche energetico) più sensato.

Oltre la connettività: nuovi mattoni di servizio tra charging, QoS, edge e fiducia

Sul fronte della “Network for AI”, secondo l’alleanza, la rete deve andare oltre la connettività e incorporare capacità che rendano sostenibili i nuovi servizi e, soprattutto, governabili gli agenti. Il focus è su programmabilità guidata da intenti, orchestrazione tra edge e dominio centrale, e una gestione dei dati e dei modelli più unificata lungo tutta la catena – dai device alle funzioni di core e RAN, fino alle application function.

Un tema che merita attenzione per le implicazioni di mercato è quello dei modelli di charging. Qui NGMN ipotizza approcci più granulari, ad esempio meccanismi “token-based” legati al consumo reale di risorse (banda, garanzie di latenza, capacità di edge computing). È un segnale di come l’AI possa spingere gli operatori a ripensare non solo la tecnica, ma anche la monetizzazione, spostando l’attenzione dal “gigabyte” al “servizio” e alla risorsa effettivamente utilizzata.

Poi c’è il capitolo fiducia. Se gli agenti agiscono per conto degli utenti, l’autenticazione reciproca, l’autorizzazione e la protezione dei prompt e dei dati personali diventano requisiti strutturali. E, come osserva il report, in un mondo di agenti che dialogano tra loro, la rete non può ignorare il problema dei contenuti malevoli generati o veicolati da sistemi automatici: servono framework di trust che aiutino identificazione e blocco, mantenendo al contempo compliance e capacità di lawful interception dove richiesto.

AI “dentro” la rete, ma con freni di sicurezza: automazione, intent e modalità agent-less

Se la rete deve servire l’AI, l’AI a sua volta diventa un acceleratore della rete. e capacità abilitante in tutti i domini dalla gestione al core, dal RAN al trasporto fino all’orchestrazione. Ma insiste su un punto che spesso manca nel dibattito ovvero che l’automazione spinta aumenta la superficie d’attacco e amplifica i rischi. Per questo sono necessari meccanismi “failsafe“, inclusa la possibilità di interrompere più agenti e, se necessario, far funzionare il sistema in modalità “agent-less”, preservando affidabilità e apertura.

Nel layer di management, l’idea è un passaggio da reti che reagiscono a reti che decidono in modo proattivo: intent-driven management, self-healing, pianificazione delle risorse, orchestrazione cross-domain. Ma la prospettiva resta “operativa” e gli intent possono essere conflittuali (prestazioni contro risparmio energetico) e, dunque, vanno gestiti con governance, auditabilità e controllo umano.

Nel RAN, NGMN sottolinea che non tutto beneficerà allo stesso modo dell’AI. Alcune funzioni già vicine all’ottimo con modelli ben definiti potrebbero ottenere guadagni marginali rispetto al costo computazionale. E qui riemerge un altro elemento critico: energia e complessità. L’AI consuma, e l’AI aggiunge entità e interfacce. L’equilibrio va cercato distribuendo i carichi dove sono più efficienti, dal cloud al bordo fino ai dispositivi, ma “solo quando” aggiungono valore misurabile.

Evoluzione, non rivoluzione: SBA 5G come base e spazio a protocolli per agenti

La parola chiave del documento è continuità. La prossima architettura non va pensata come pagina bianca ma come evoluzione del 5G Service-Based Architecture: i casi d’uso “value-driven” devono essere presi d’esempio per evitare scelte radicali che non abbiano ritorni di investimento chiari.

Protocolli come Model Context Protocol (MCP) e comunicazioni agent-to-agent (A2A) sono possibili strumenti complementari alle API esistenti, senza sostituirle quando queste risultano adeguate. L’idea è che agenti possano accedere a risorse e API delle network function attraverso meccanismi di comunicazione dedicati, mentre l’architettura SBA resta il perno, “senza evoluzioni drastiche”.

C’è anche un tema di trasporto. Se le interazioni diventano più “transazionali” e intensive, con scambi frequenti tra RAN e core o tra agenti e funzioni, si può ipotizzare una valutazione di protocolli più efficienti, citando QUIC (Quick UDP Internet Connections) come esempio per evolvere le interfacce di control plane in scenari futuri.

Interoperabilità multi-vendor e rischio “obsolescenza standard”: come non congelare l’innovazione

Due sono i rischi che il report mette sul tavolo con più realismo. Il primo è quello della frammentazione: in un ecosistema disaggregato e multi-vendor, servono framework di interoperabilità e trust che rendano scalabili e sicure le integrazioni, compresi aspetti come retraining e fine-tuning dei modelli. Il secondo è temporale: l’AI corre così velocemente che c’è il pericolo concreto di standardizzare funzioni e protocolli che al momento del dispiegamento risultino già superati.

Per questo NGMN invita 3GPP e gli altri organismi a interrogarsi su cosa abbia senso standardizzare formalmente e cosa possa invece essere lasciato a pratiche de facto, con un approccio simile a quanto avvenuto nel 5G core con l’adozione industriale di microservizi e orchestrazione container. L’obiettivo è evitare vincoli che soffochino l’emergere di nuovi casi d’uso, ma senza sacrificare interoperabilità e riduzione della complessità di integrazione.

“La rapida evoluzione dei modelli di IA su larga scala sta guidando un cambiamento verso un ambiente sempre più AI-native – sottolinea Takki Yu, membro del Consiglio di Amministrazione di NGMN e VP, Head of Network Tech Office di SK Telecom – Per supportare questa trasformazione, le reti dovranno introdurre progressivamente capacità abilitate dall’IA, come la programmabilità guidata dagli intenti, l’operatività autonoma e la distribuzione dinamica della capacità di calcolo tra i domini edge e centrali. Allineando fin da subito le principali priorità di standardizzazione, l’industria può garantire che il 6G evolva in modo flessibile, sostenibile e orientato alla creazione di valore”.

E la CEO Anita Döhler chiude il cerchio sul perché NGMN stia spingendo così forte su questi temi: “La proliferazione dei casi d’uso dell’IA, in particolare quelli con capacità autonome e guidate da compiti, sta rapidamente rimodellando il modo in cui le reti vengono costruite e gestite – puntualizza la CEO di NGMN, Anita Döhler – Mentre il settore accelera verso la prossima era della connettività, NGMN sta affinando il proprio focus sull’evoluzione delle reti del futuro, ponendo l’accento sulla flessibilità necessaria ad accogliere l’evoluzione del 6G guidata dall’IA”.

Una “checklist” implicita per l’industria: adattabilità, sostenibilità, fiducia e migrazione morbida

La “ricetta” proposta, in conclusione, si basa su quattro ingredienti chiave: adattabilità come proprietà fondamentale, sostenibilità come vincolo non negoziabile, trustworthiness come prerequisito per agenti e dati, e una migrazione che non rompa ciò che funziona. Perché la rete del prossimo decennio possadiventare una piattaforma capace di ospitare servizi e agenti in modo più nativo, ma con una governance che tenga insieme tecnologia, operazioni e ritorno economico.