Nel contesto della trasformazione digitale, i Big Data rappresentano un elemento abilitante fondamentale per tutte le altre tecnologie emergenti. La capacità di raccogliere, memorizzare, elaborare e interpretare volumi enormi di dati eterogenei ha rivoluzionato l’approccio alla conoscenza, alla previsione e alla decisione in ogni ambito economico e sociale.

La crescita dei dati digitali è stata esponenziale: ogni giorno nel mondo vengono generati miliardi di terabyte di informazioni provenienti da sensori, dispositivi mobili, reti sociali, sistemi informativi aziendali e infrastrutture pubbliche. Questa mole di dati non è solo quantità: la varietà (strutturati, semi-strutturati, non strutturati), la velocità di generazione e la veridicità (qualità e affidabilità) pongono sfide rilevanti ma anche opportunità enormi.

Indice degli argomenti

L’evoluzione dei dati digitali

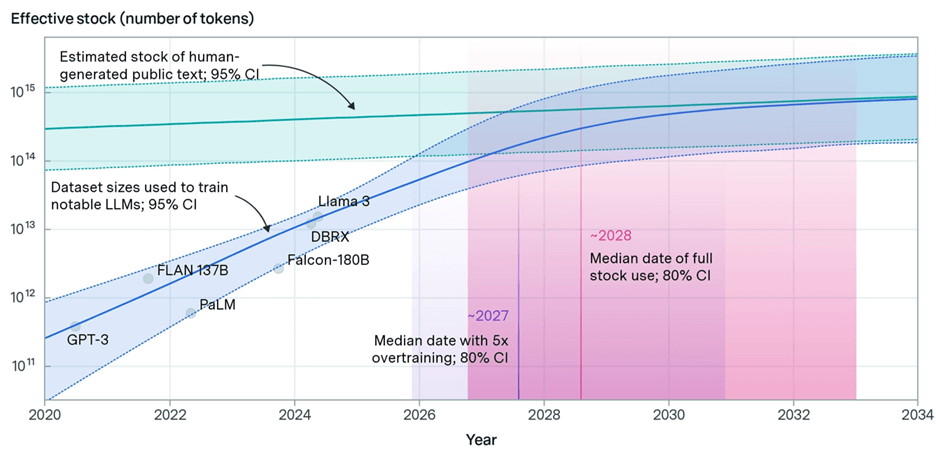

La Figura sottostante sulla quantità disponibile di testi e dati digitali per uso pubblico secondo EPOCH AI del 2025 mostra l’evoluzione della produzione di dati digitali fino al 2035 e Illustra in modo visivo come la quota di dati forniti all’intelligenza artificiale crescerà progressivamente entro quel decennio. L’Intelligenza Artificiale generativa, come i moderni modelli linguistici e visivi, si basano su una risorsa cruciale: i dati digitali di alta qualità prodotti dall’umanità, fino ad oggi e negli anni a venire. Secondo studi emersi nel 2025, il pianeta starebbe raggiungendo — o avrebbe già raggiunto — il limite massimo di dati utili disponibili per l’addestramento delle IA. Questo “muro di dati” (data wall) rappresenta un punto critico e affascinante nella traiettoria dell’innovazione.

Nonostante l’esaurimento dei dati “vecchi”, la produzione globale di nuovi contenuti digitali continuerà a crescere fino al 2035 e oltre. Tuttavia, una percentuale crescente di questi nuovi dati sarà generata dagli stessi sistemi di intelligenza artificiale. Le stime parlano di percentuali sempre più importanti (c’è chi stima il 25-35% entro il 2035).

Questo presenta una sfida concettuale: può l’IA addestrarsi su contenuti generati da IA? L’autosomministrazione di dati rischia di creare loop informativi, rinforzando errori, bias o allucinazioni. I contenuti sintetici possono mancare di diversità semantica, contestuale o pragmatica rispetto all’esperienza umana. Il modello potrebbe diventare “autoreferenziale”, perdendo contatto con la realtà digitale circostante e il pensiero umano. Tuttavia, con adeguati controlli di qualità, modelli ibridi e tecniche di supervisione umana, i dati generatidall’IA possono costituire una risorsa preziosa – a patto che siano trattati come complemento e non come unica fonte.

Una sfida senza precedenti

Il raggiungimento del limite dei dati rappresenta una sfida senza precedenti, ma anche una straordinaria occasione per l’innovare l’IA: l’inizio di una nuova fase creativa. La scarsità obbliga il settore a: reinventare i metodi di addestramento, investire in architetture più efficienti e “frugali”, rivalutare il ruolo dell’interazione umana nell’affinamento dell’intelligenza artificiale.

Le tecnologie di analytics, potenziate dall’intelligenza artificiale e dal machine learning, permettono di trasformare questi dati in insight utili per il business, la salute pubblica, la pianificazione urbana, la gestione ambientale e la sicurezza. Si parla oggi di analytics descrittivi, predittivi e prescrittivi, capaci di fornire un supporto evoluto alle decisioni, anticipando scenari futuri e suggerendo le azioni più efficaci.

Il boom dei data analytics e il nodo privacy

Il mercato globale dei Big Data & Analytics è uno dei segmenti in più rapida crescita: secondo le stime, esso supererà i 250 miliardi di dollari entro il 2029, con un CAGR del 14,6%. Le applicazioni sono trasversali: dalle analisi comportamentali nel retail e nel marketing digitale, alle predizioni nella finanza, dalla genomica personalizzata alla manutenzione predittiva nell’industria.

Una sfida crescente riguarda la protezione dei dati personali e la gestione etica degli algoritmi. L’adozione di standard di governance dei dati, di architetture trasparenti e di tecnologie privacy-preserving (come la federated learning o la crittografia omomorfica) diventa sempre più cruciale.

L’analisi avanzata dei dati è ormai una funzione core delle organizzazioni data-driven, che costruiscono vantaggio competitivo sulla capacità di comprendere in profondità fenomeni complessi e di agire tempestivamente con strategie fondate su evidenze quantitative. La combinazione tra Big Data, AI e cloud costituisce il nucleo dell’intelligenza digitale contemporanea, aprendo la strada alla prossima rivoluzione della conoscenza automatica.