In un’epoca in cui l’intelligenza artificiale (AI) e l’automazione si vanno confermando come i pilastri dell’innovazione tecnologica, la qualità dei dati su cui si basano queste tecnologie diventa cruciale. Tuttavia, una recente analisi di TeckNexus ha messo in luce un problema spesso trascurato: la proliferazione di “dirty data” nei data center, ovvero dati duplicati, incompleti o inaccurati, che compromettono l’efficacia dell’AI e dell’automazione.

l’analisi

Dati “sporchi”, il tallone d’Achille dei data center evoluti

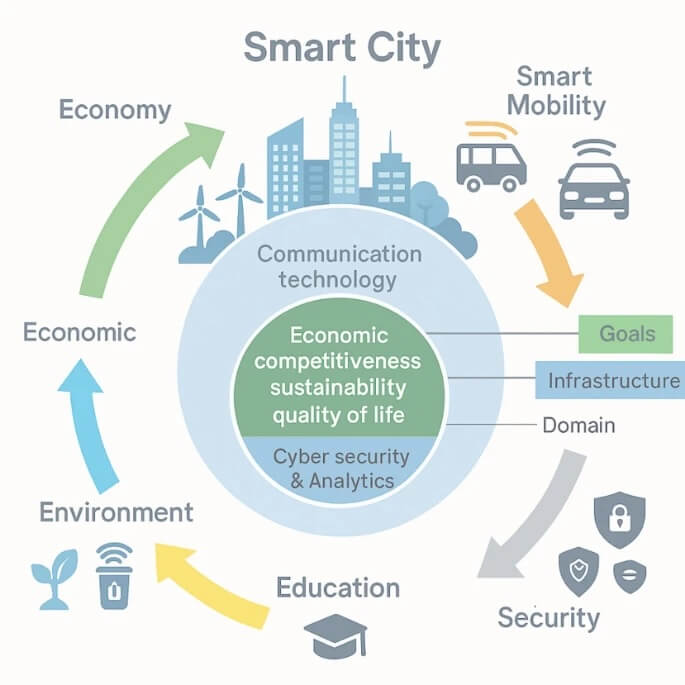

Una nuova indagine rivela che oltre 215 miliardi di eventi mensili di informazione non autorizzate alimentano modelli di intelligenza artificiale, mettendo a rischio l’efficienza e la conformità delle infrastrutture digitali

Continua a leggere questo articolo

Aziende

Argomenti

Canali

Con o Senza – Galaxy AI per il business