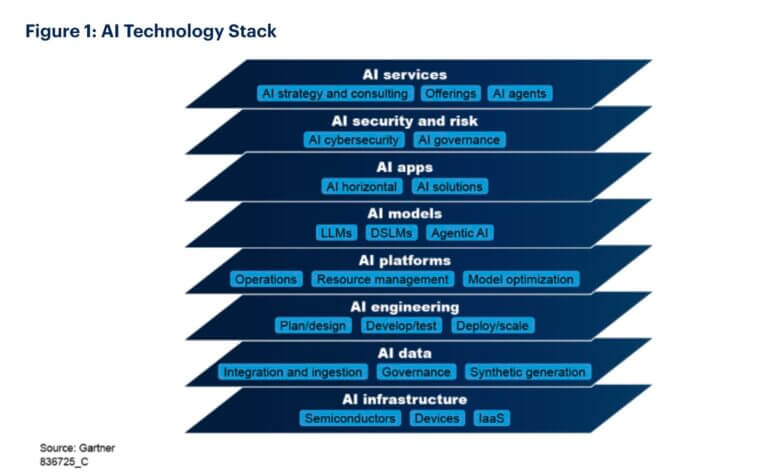

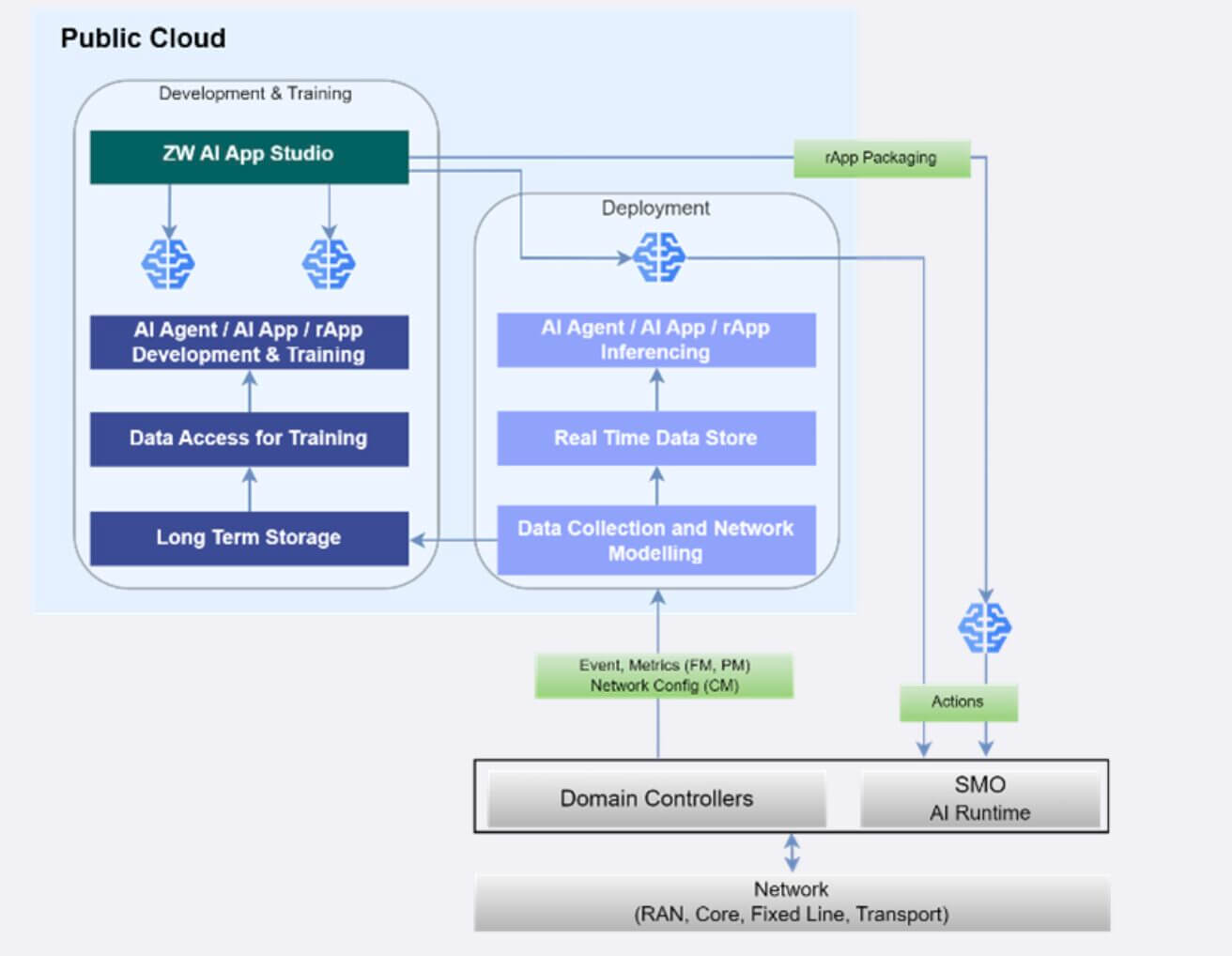

Le reti autonome non sono più un concetto futuristico, ma una realtà in costruzione. La visione di infrastrutture telco capaci di operare con minima o nulla supervisione umana si sta concretizzando grazie alla convergenza tra Intelligenza Artificiale (AI) e Digital Twin. Questa trasformazione rappresenta un cambio di paradigma per i Communication Service Provider (Csp), che si trovano di fronte a una sfida strategica: ripensare la gestione delle reti in chiave automatizzata, predittiva e resiliente.

innovazione

Zero-wait, zero-touch, zero-trouble: si apre l’era delle reti autonome. Tlc pronte alla svolta?

La visione di infrastrutture capaci di operare con minima o nulla supervisione umana sta diventando realtà grazie alla convergenza tra AI e digital twin. Un cambio di paradigma per i Communication Service Provider

Continua a leggere questo articolo

Argomenti

Canali

Con o Senza – Galaxy AI per il business